动画详解Transformer模型以及变形模型

课时介绍

课程介绍

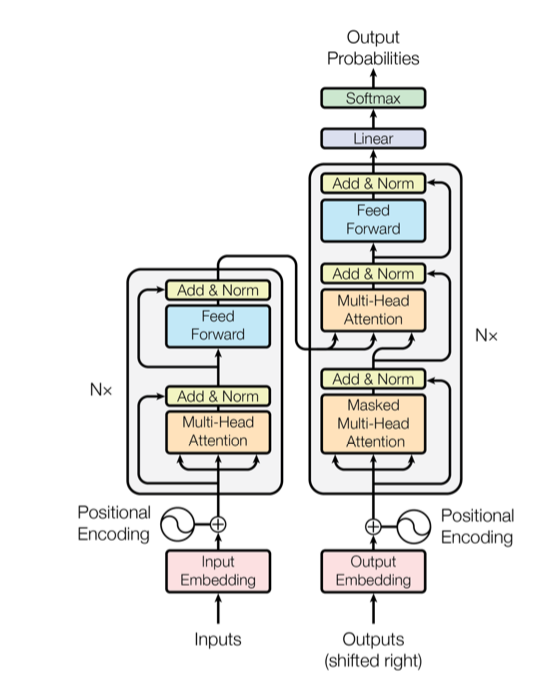

Transformer在论文Attention is All You Need提出,本专栏按照视频,图文,代码三个维度来介绍,并详细介绍VIT与Swin 2个模型

Transformer是Google在论文Attention is All You Need提出的概念,本专栏按照视频动画,图文详解,代码分析来彻底搞懂其模型

NLP领域中近年来,研究最火热的模型当属transformer模型了,很多小伙伴初次看到transformer模型的架构图与论文后,仍然一头雾水

1、什么是自注意力机制?

2、为何需要位置编码

3、模型中的多头与mask 多头注意力机制又有啥区别

4、编码器的输入为何还有一个shifted input

5、Vision transformer与swin transformer诸多细节

本专栏按照视频,图文,代码分析等多角度来详解解读transformer模型的各个细节,让你彻底搞懂transformer模型

Transformer 在NLP领域大火,其已经在CV领域大放异彩

VIsion Transformer 与Swin Transformer延续Transformer 模型的注意力机制,应用到计算机视觉领域

信息系统项目管理师自考笔记

李明 · 980人在学

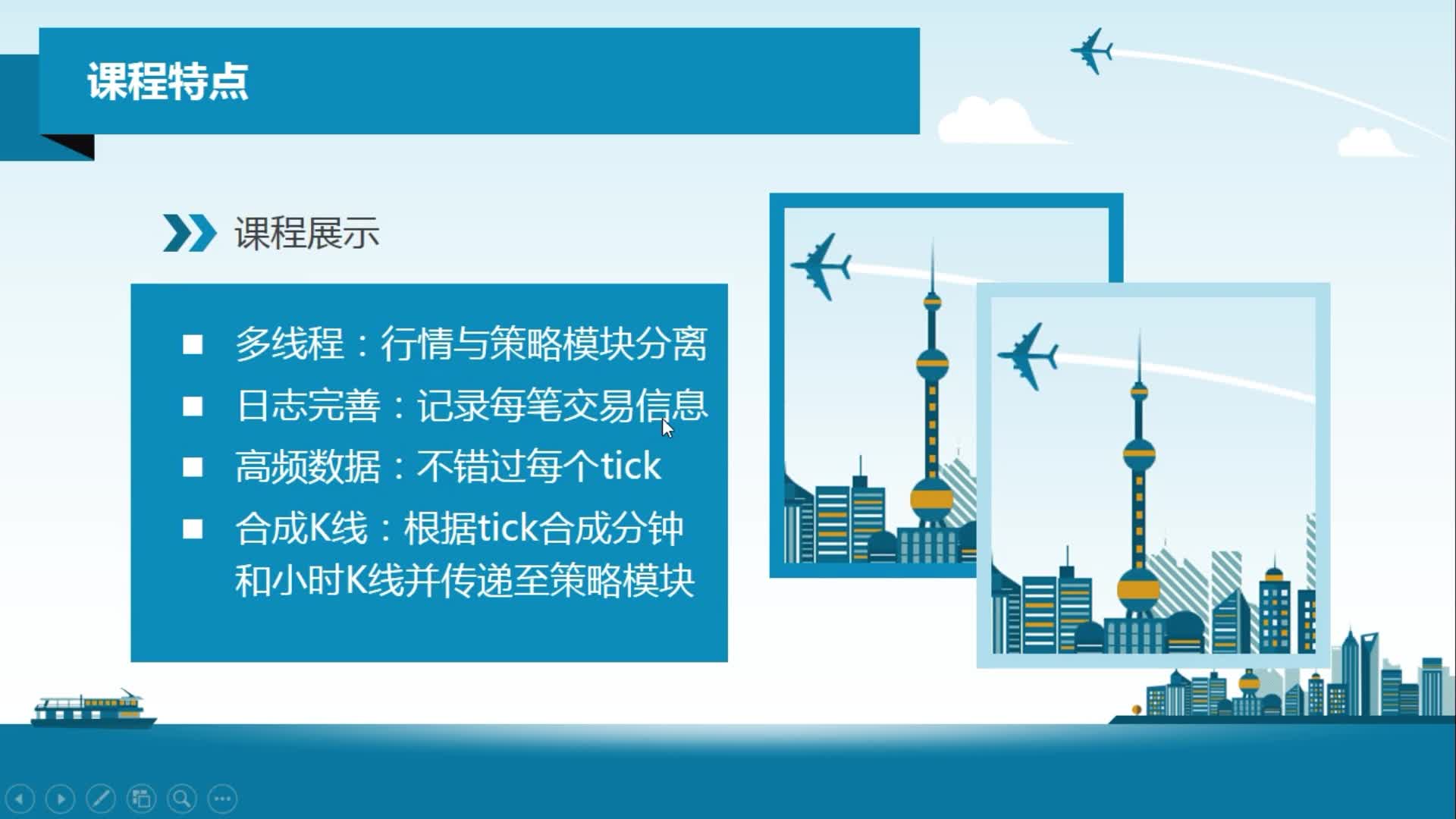

python从0到1:期货量化交易系统(CTP实战,高频及合成K线数据

王先生 · 23049人在学

手把手搭建Java超市管理系统【附源码】(毕设)

汤小洋 · 4321人在学

Java毕设springboot外卖点餐系统 毕业设计毕设源码 使用教

黄菊华 · 849人在学

基于SSM酒店管理系统(毕设)

小尼老师 · 910人在学

java项目实战之购物商城(java毕业设计)

Long · 5217人在学

手把手搭建Java求职招聘系统【附源码】(毕设)

汤小洋 · 1541人在学

Python Django 深度学习 小程序

钟翔 · 2438人在学

城管局门前三包管理系统+微信小程序(vue+springboot)

赖国荣 · 714人在学

Vue+Uni-app(uniapp)入门与实战+赠送仿美团点餐小程序

李杰 · 4105人在学