掌握大模型应用开发,从基础到高级全面进阶

熟练使用Dify与Xinference,增强模型部署技能

深入理解RAGFlow,有效解决复杂数据问答问题

构建企业级智能系统,实际应用经验大幅提升

你将收获

掌握大模型应用开发,从基础到高级全面进阶

熟练使用Dify与Xinference,增强模型部署技能

深入理解RAGFlow,有效解决复杂数据问答问题

构建企业级智能系统,实际应用经验大幅提升

适用人群

课程介绍

在当今快速发展的技术世界中,掌握大模型应用开发技能已成为追求卓越职业生涯的关键。由云馨AI精心打造的“大模型应用开发:Java+Dify+RAGFlow+Xinference智能问答系统实战”课程,为您提供了一个从零开始学习直至精通的机会,帮助您成为大模型应用领域的专家。

本课程无论您是编程新手还是已有一定基础的技术爱好者,都将在这里找到属于您的成长路径。课程内容涵盖了从虚拟机搭建、Docker和docker-compose等基础软件安装开始,到逐步掌握Dify的开发技能,包括但不限于模型配置、应用管理以及工作流编排等核心功能;学习如何部署Xinference模型,如LLM模型、Embedding Models和Rerank models等,让您的知识体系更加完善。

更进一步,我们将探索RAGFlow的知识库搭建,通过深度文档理解驱动的开源RAG引擎,解决复杂格式数据问答的难题。最终,您将学会如何使用Java结合Dify、RAGFlow和Xinference搭建企业级智能问答系统,实现制度问答、联网搜索以及基于文档上传的智能问答等功能。

参加本课程,您不仅能够获得构建智能客服系统、企业知识库等实际项目的宝贵经验,还能为未来的职业发展奠定坚实的基础。无论是为了提升个人竞争力,还是寻求职业转型,这里都有您需要的一切资源和支持。

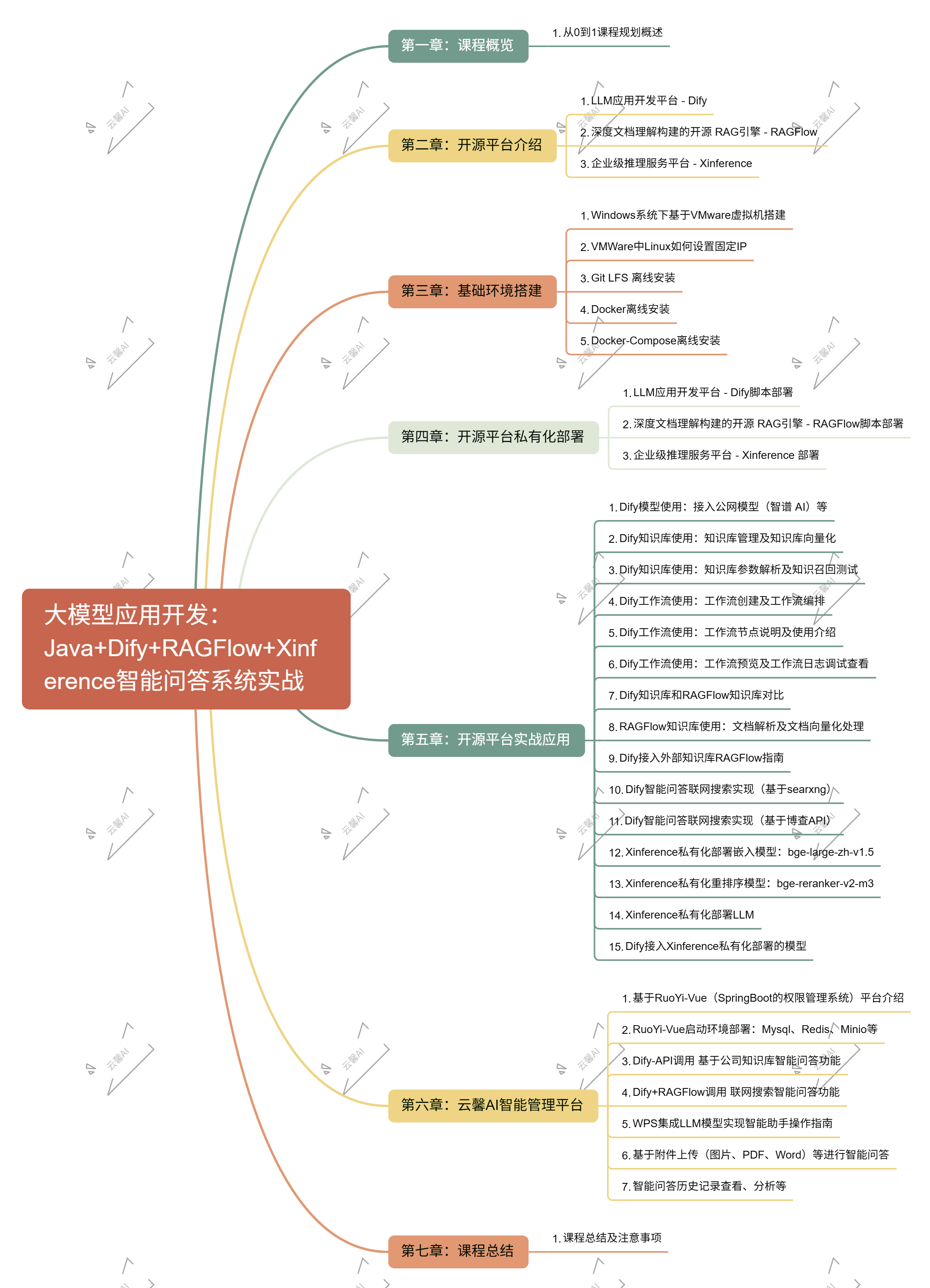

课程目录