Tensorflow2.x与神经网络实战

课时介绍

计算神经网络的梯度

课程介绍

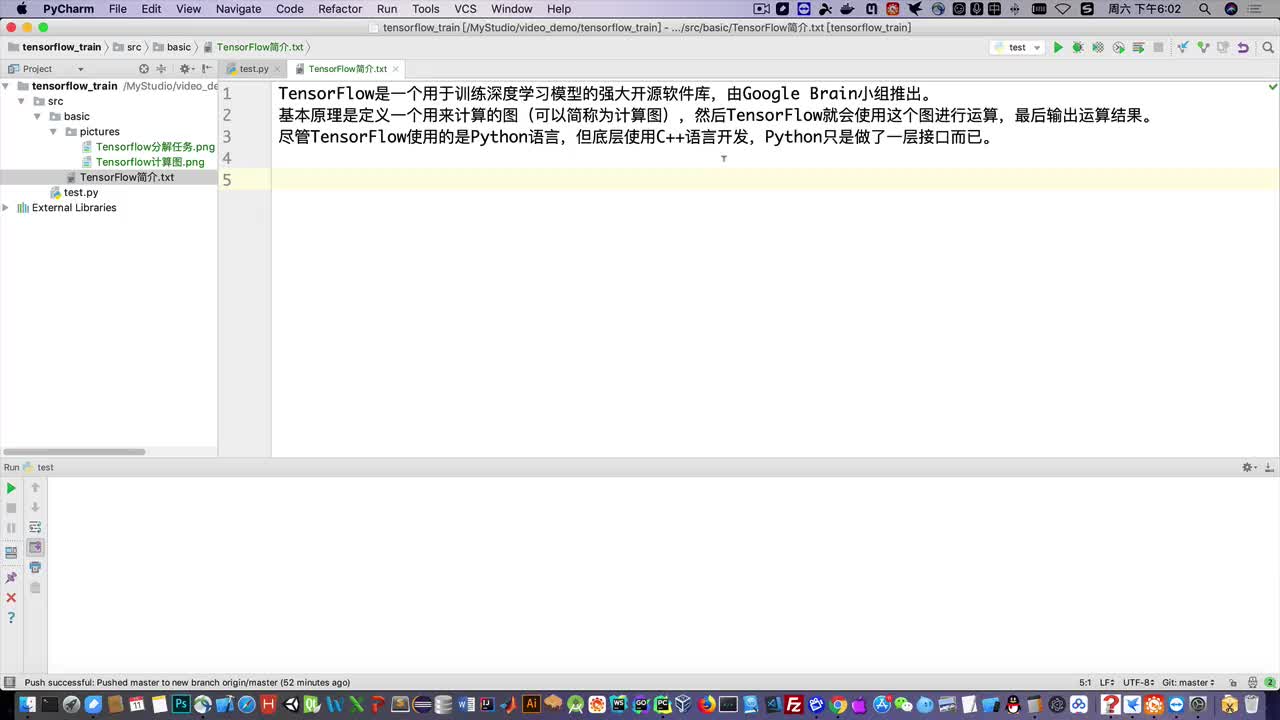

本课程使用了TensorFlow 2.x录制。

本课程采用Python 3.x录制,适合于Python3.5及以上的所有Python版本。视频以及源代码适合于Windows、macOS和Linux系统。

包含了Tensorflow2.x和神经网络的核心知识,包括tensorflow的基本用法,感知机,神经网络原理等

推荐课程

信息系统项目管理师自考笔记

李明 · 980人在学

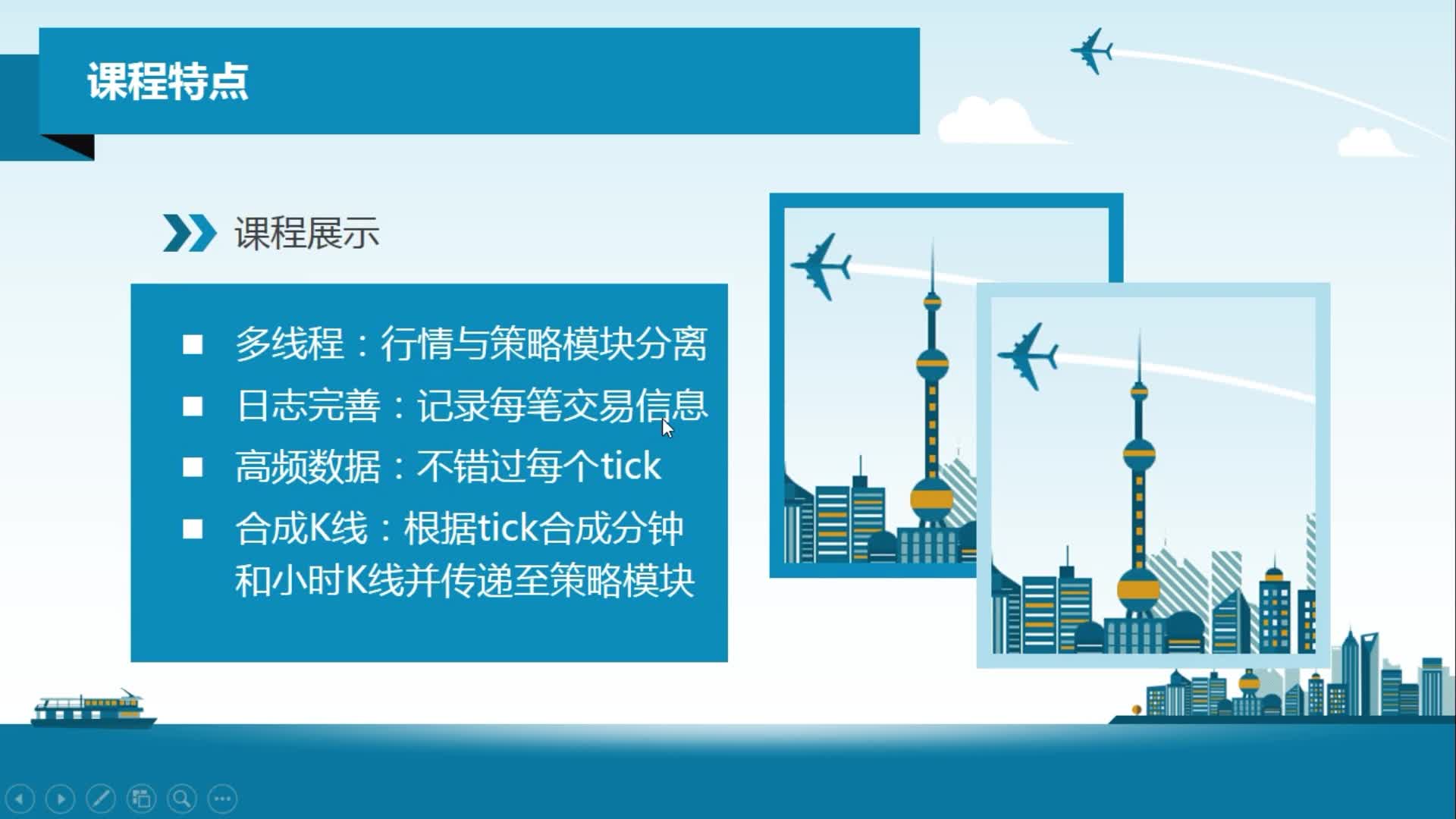

python从0到1:期货量化交易系统(CTP实战,高频及合成K线数据

王先生 · 23054人在学

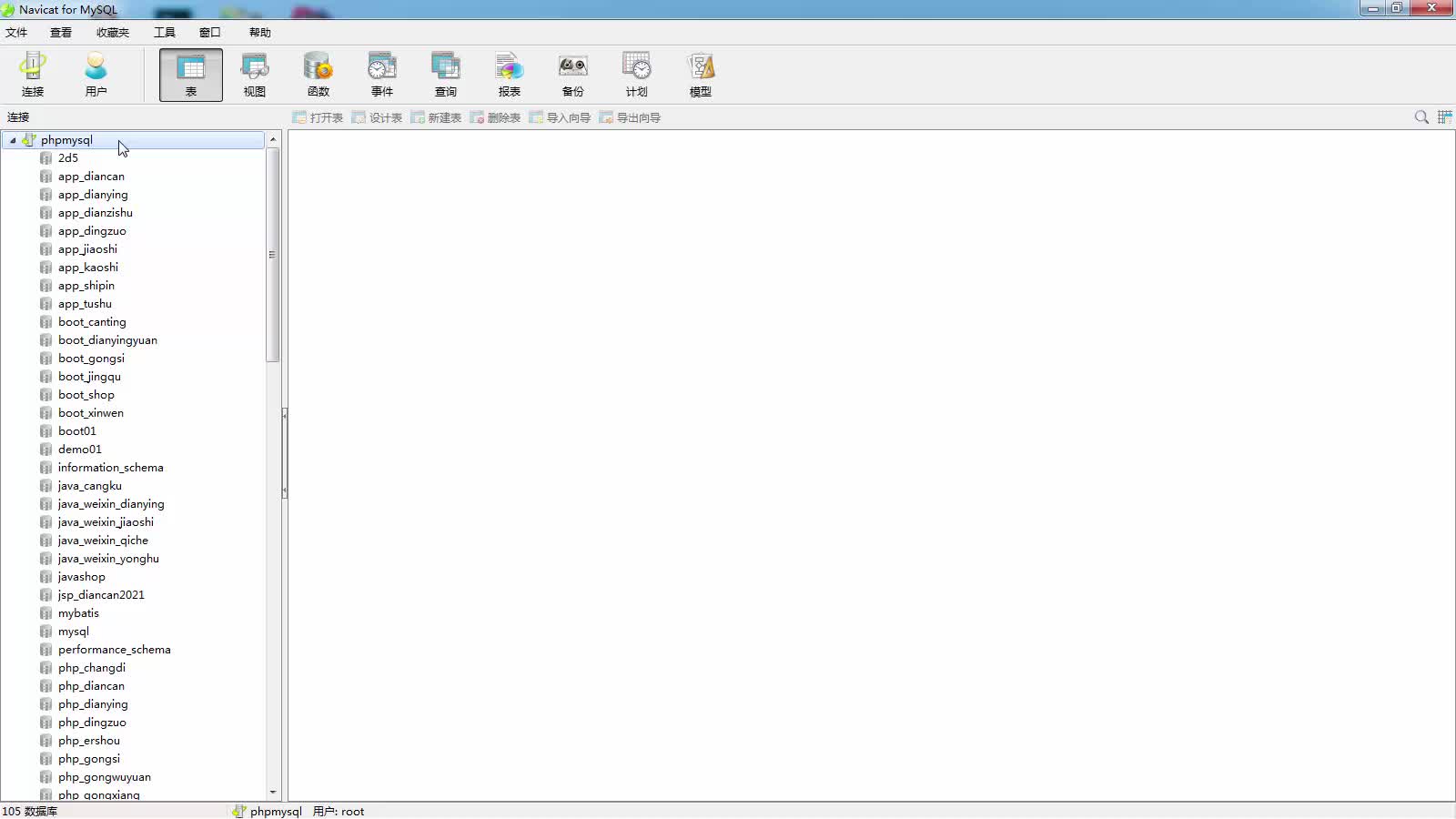

手把手搭建Java超市管理系统【附源码】(毕设)

汤小洋 · 4321人在学

Java毕设springboot外卖点餐系统 毕业设计毕设源码 使用教

黄菊华 · 850人在学

基于SSM酒店管理系统(毕设)

小尼老师 · 910人在学

java项目实战之购物商城(java毕业设计)

Long · 5217人在学

手把手搭建Java求职招聘系统【附源码】(毕设)

汤小洋 · 1541人在学

Python Django 深度学习 小程序

钟翔 · 2439人在学

城管局门前三包管理系统+微信小程序(vue+springboot)

赖国荣 · 714人在学

Vue+Uni-app(uniapp)入门与实战+赠送仿美团点餐小程序

李杰 · 4105人在学