包含课程

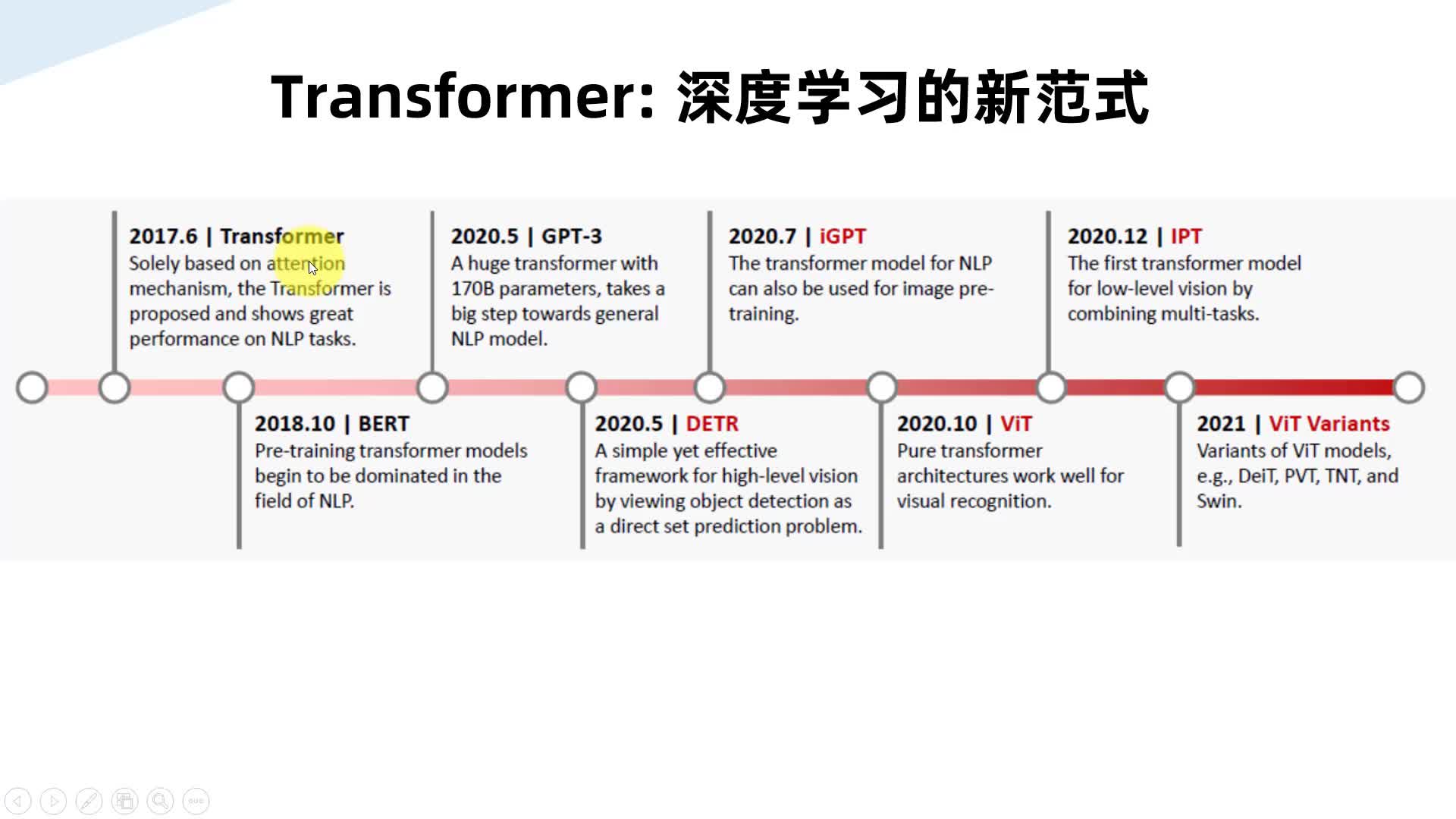

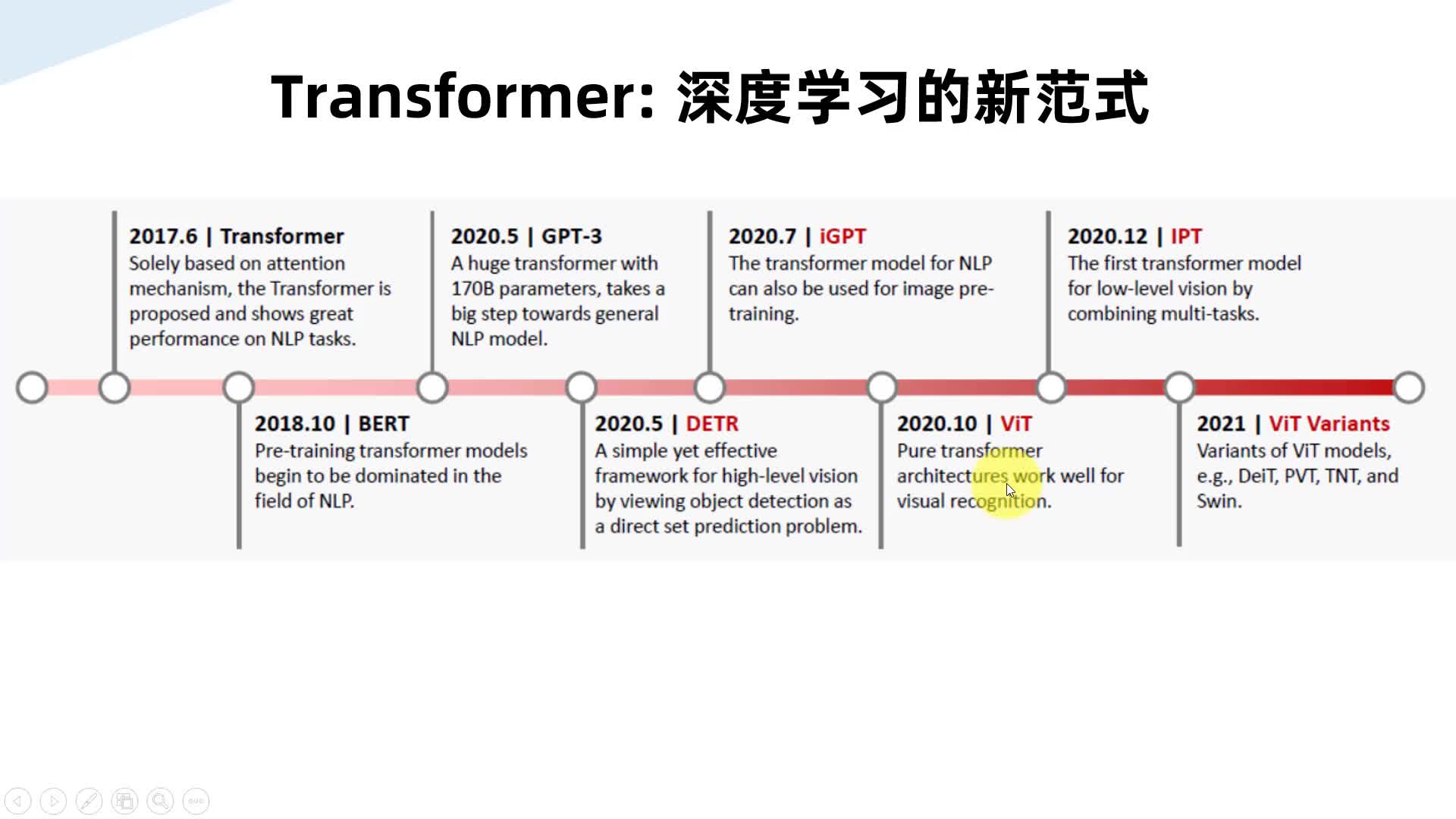

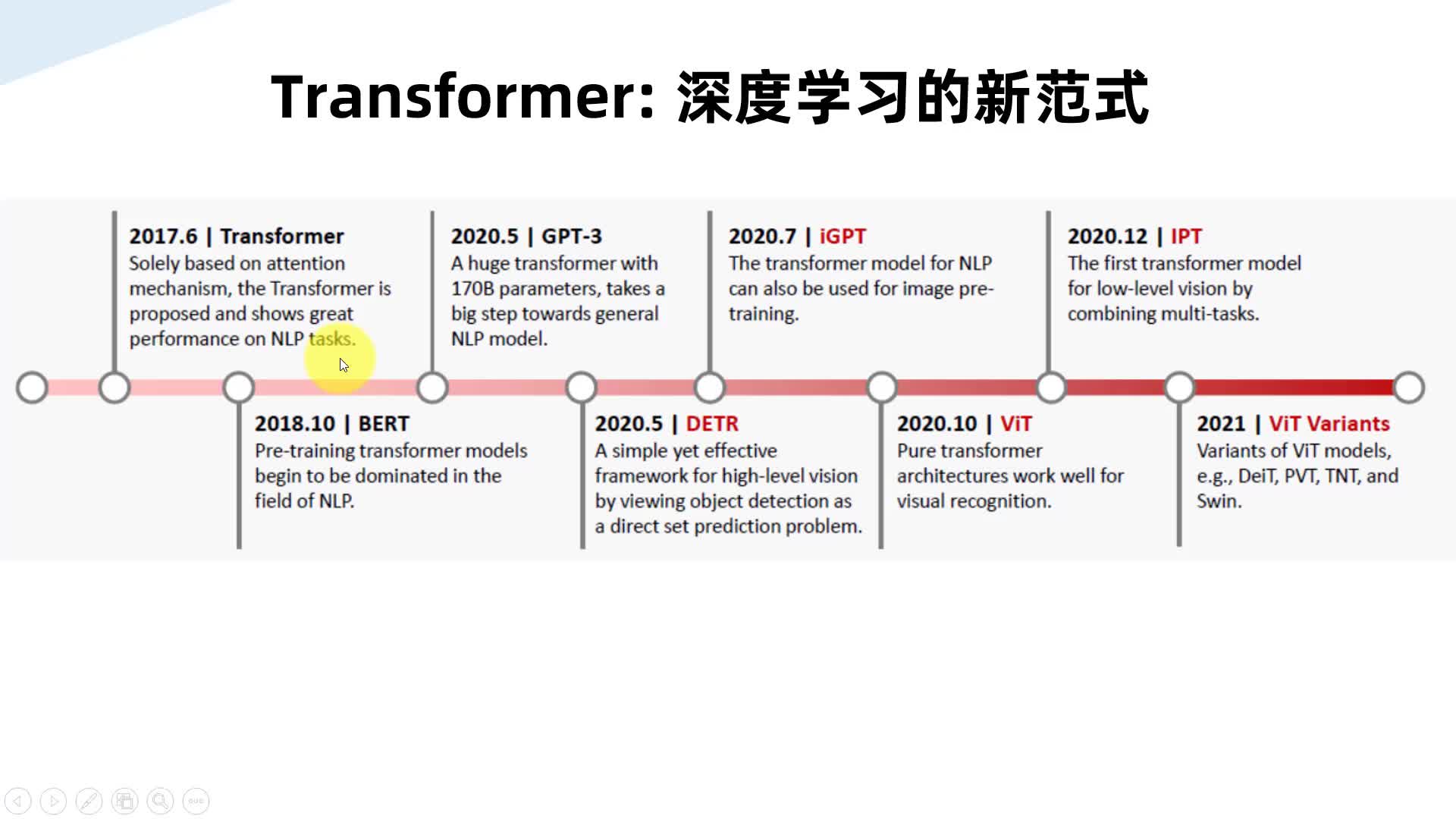

3958人 学习人数5.0分 课程评分Swin Transformer实战目标检测:训练自己的数据集Transformer发轫于NLP(自然语言处理),并跨界应用到CV(计算机视觉)领域。 Swin Transformer是基于Transformer的计算机视觉骨干网,在图像分类、目标检测、实例分割、语义分割等多项下游CV应用中取得了SOTA的性能。该项工作也获得了ICCV 2021顶会最佳论文奖。 本课程将手把手地教大家使用labelImg标注和使用Swin Transformer训练自己的数据集。 本课程将介绍Transformer及在CV领域的应用、Swin Transformer的原理。 课程以多目标检测(足球和梅西同时检测)为例进行Swin Transformer实战演示。 课程在Windows和Ubuntu系统上分别做项目演示。包括:安装软件环境、安装Pytorch、安装Swin-Transformer-Object-Detection、标注自己的数据集、准备自己的数据集(自动划分训练集和验证集)、数据集格式转换(Python脚本完成)、修改配置文件、训练自己的数据集、测试训练出的网络模型、性能统计、日志分析。 相关课程: 《Transformer原理与代码精讲(PyTorch)》https://edu.csdn.net/course/detail/36697《Transformer原理与代码精讲(TensorFlow)》https://edu.csdn.net/course/detail/36699《ViT(Vision Transformer)原理与代码精讲》https://edu.csdn.net/course/detail/36719《DETR原理与代码精讲》https://edu.csdn.net/course/detail/36768《Swin Transformer实战目标检测:训练自己的数据集》https://edu.csdn.net/course/detail/36585《Swin Transformer实战实例分割:训练自己的数据集》https://edu.csdn.net/course/detail/36586 <https://edu.csdn.net/course/detail/36586>《Swin Transformer原理与代码精讲》 https://download.csdn.net/course/detail/37045计算机视觉目标检测transformer人工智能物体检测

3958人 学习人数5.0分 课程评分Swin Transformer实战目标检测:训练自己的数据集Transformer发轫于NLP(自然语言处理),并跨界应用到CV(计算机视觉)领域。 Swin Transformer是基于Transformer的计算机视觉骨干网,在图像分类、目标检测、实例分割、语义分割等多项下游CV应用中取得了SOTA的性能。该项工作也获得了ICCV 2021顶会最佳论文奖。 本课程将手把手地教大家使用labelImg标注和使用Swin Transformer训练自己的数据集。 本课程将介绍Transformer及在CV领域的应用、Swin Transformer的原理。 课程以多目标检测(足球和梅西同时检测)为例进行Swin Transformer实战演示。 课程在Windows和Ubuntu系统上分别做项目演示。包括:安装软件环境、安装Pytorch、安装Swin-Transformer-Object-Detection、标注自己的数据集、准备自己的数据集(自动划分训练集和验证集)、数据集格式转换(Python脚本完成)、修改配置文件、训练自己的数据集、测试训练出的网络模型、性能统计、日志分析。 相关课程: 《Transformer原理与代码精讲(PyTorch)》https://edu.csdn.net/course/detail/36697《Transformer原理与代码精讲(TensorFlow)》https://edu.csdn.net/course/detail/36699《ViT(Vision Transformer)原理与代码精讲》https://edu.csdn.net/course/detail/36719《DETR原理与代码精讲》https://edu.csdn.net/course/detail/36768《Swin Transformer实战目标检测:训练自己的数据集》https://edu.csdn.net/course/detail/36585《Swin Transformer实战实例分割:训练自己的数据集》https://edu.csdn.net/course/detail/36586 <https://edu.csdn.net/course/detail/36586>《Swin Transformer原理与代码精讲》 https://download.csdn.net/course/detail/37045计算机视觉目标检测transformer人工智能物体检测

3087人 学习人数5.0分 课程评分Swin Transformer实战实例分割:训练自己的数据集Transformer发轫于NLP(自然语言处理),并跨界应用到CV(计算机视觉)领域。 Swin Transformer是基于Transformer的计算机视觉骨干网,在图像分类、目标检测、实例分割、语义分割等多项下游CV应用中取得了SOTA的性能。该项工作也获得了ICCV 2021顶会最佳论文奖。本课程将手把手地教大家使用labelme标注和使用Swin Transformer训练自己的数据集进行图片和视频的实例分割。 本课程将介绍Transformer及在CV领域的应用、Swin Transformer的原理。 本课程以汽车驾驶场景图片和视频开展项目实践:对汽车行驶场景中的路坑、车、车道线进行物体标注和实例分割。 课程在Windows和Ubuntu系统上分别做项目演示。包括:安装软件环境、安装Pytorch、安装Swin-Transformer-Object-Detection、标注自己的数据集、准备自己的数据集、数据集格式转换(Python脚本完成)、修改配置文件、训练自己的数据集、测试训练出的网络模型、性能统计、日志分析。 本课程提供项目的数据集和相关Python程序文件。相关课程: 《Transformer原理与代码精讲(PyTorch)》https://edu.csdn.net/course/detail/36697《Transformer原理与代码精讲(TensorFlow)》https://edu.csdn.net/course/detail/36699《ViT(Vision Transformer)原理与代码精讲》https://edu.csdn.net/course/detail/36719《DETR原理与代码精讲》https://edu.csdn.net/course/detail/36768《Swin Transformer实战目标检测:训练自己的数据集》https://edu.csdn.net/course/detail/36585《Swin Transformer实战实例分割:训练自己的数据集》https://edu.csdn.net/course/detail/36586 <https://edu.csdn.net/course/detail/36586>《Swin Transformer原理与代码精讲》 https://download.csdn.net/course/detail/37045Transformer实例分割计算机视觉人工智能Swin

3087人 学习人数5.0分 课程评分Swin Transformer实战实例分割:训练自己的数据集Transformer发轫于NLP(自然语言处理),并跨界应用到CV(计算机视觉)领域。 Swin Transformer是基于Transformer的计算机视觉骨干网,在图像分类、目标检测、实例分割、语义分割等多项下游CV应用中取得了SOTA的性能。该项工作也获得了ICCV 2021顶会最佳论文奖。本课程将手把手地教大家使用labelme标注和使用Swin Transformer训练自己的数据集进行图片和视频的实例分割。 本课程将介绍Transformer及在CV领域的应用、Swin Transformer的原理。 本课程以汽车驾驶场景图片和视频开展项目实践:对汽车行驶场景中的路坑、车、车道线进行物体标注和实例分割。 课程在Windows和Ubuntu系统上分别做项目演示。包括:安装软件环境、安装Pytorch、安装Swin-Transformer-Object-Detection、标注自己的数据集、准备自己的数据集、数据集格式转换(Python脚本完成)、修改配置文件、训练自己的数据集、测试训练出的网络模型、性能统计、日志分析。 本课程提供项目的数据集和相关Python程序文件。相关课程: 《Transformer原理与代码精讲(PyTorch)》https://edu.csdn.net/course/detail/36697《Transformer原理与代码精讲(TensorFlow)》https://edu.csdn.net/course/detail/36699《ViT(Vision Transformer)原理与代码精讲》https://edu.csdn.net/course/detail/36719《DETR原理与代码精讲》https://edu.csdn.net/course/detail/36768《Swin Transformer实战目标检测:训练自己的数据集》https://edu.csdn.net/course/detail/36585《Swin Transformer实战实例分割:训练自己的数据集》https://edu.csdn.net/course/detail/36586 <https://edu.csdn.net/course/detail/36586>《Swin Transformer原理与代码精讲》 https://download.csdn.net/course/detail/37045Transformer实例分割计算机视觉人工智能Swin

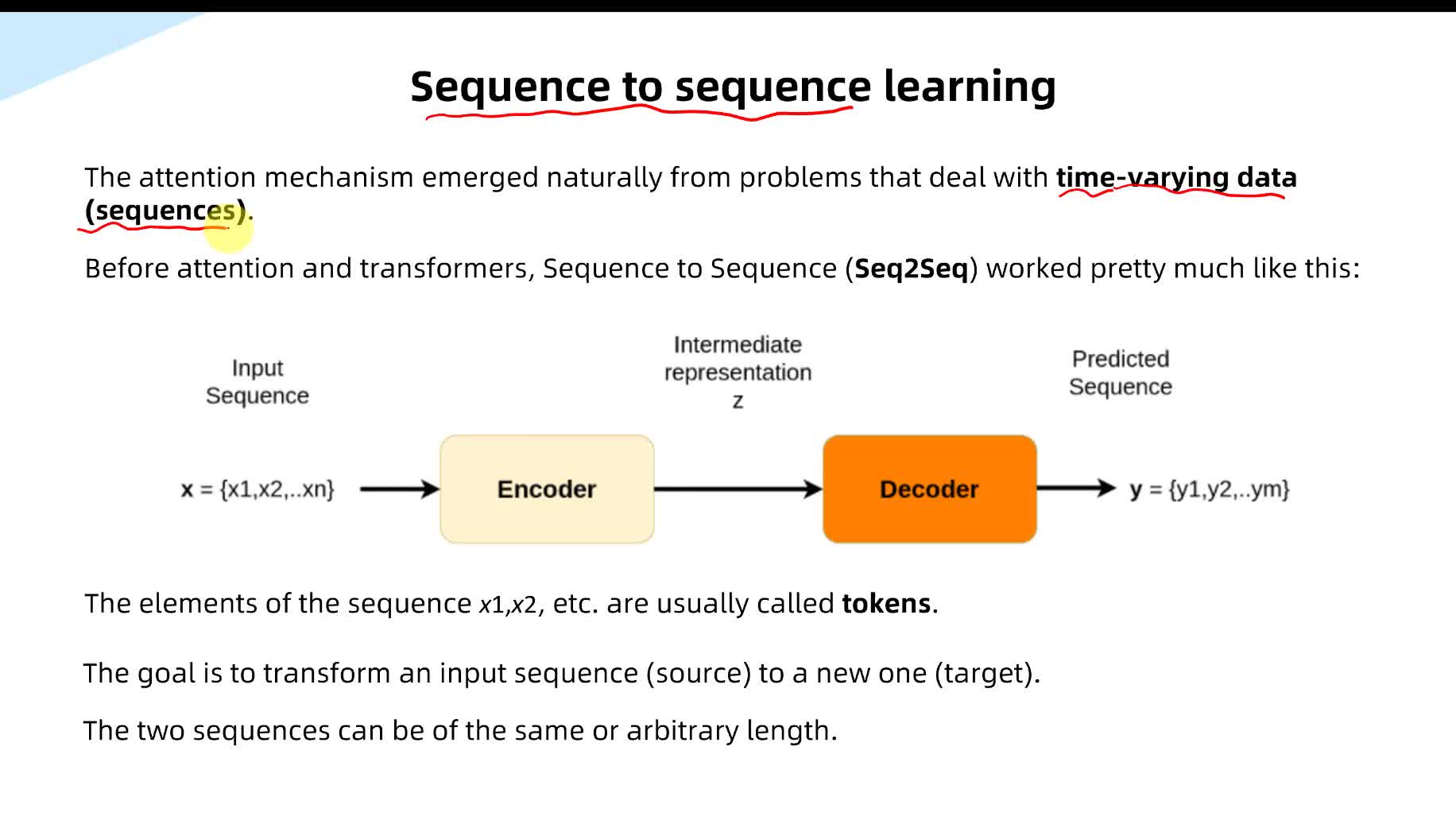

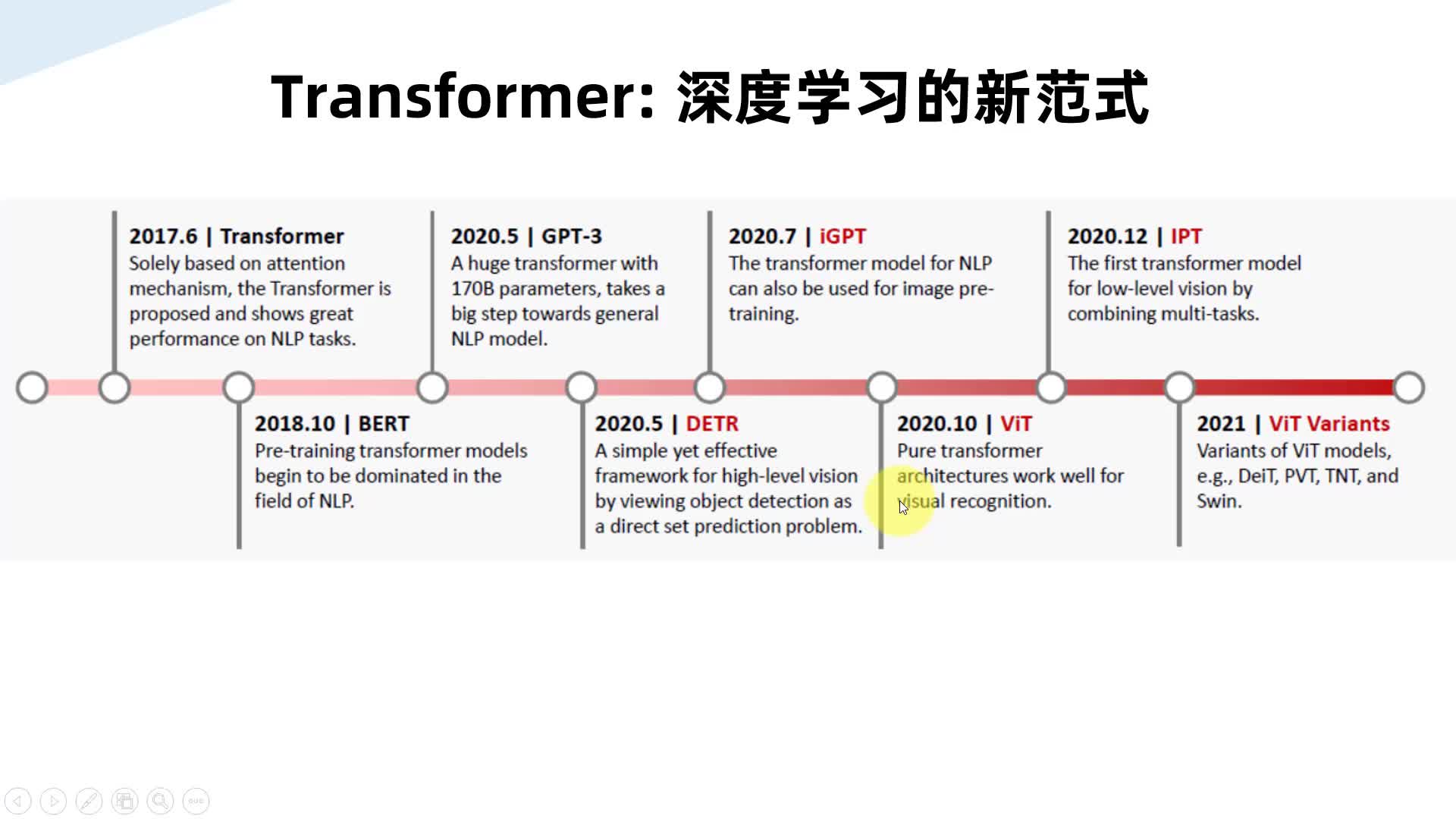

3250人 学习人数4.8分 课程评分Transformer原理与代码精讲(PyTorch)Transformer发轫于NLP(自然语言处理),并跨界应用到CV(计算机视觉)领域。目前已成为深度学习的新范式,影响力和应用前景巨大。 本课程对Transformer的原理和PyTorch代码进行精讲,来帮助大家掌握其详细原理和具体实现。 原理精讲部分包括:注意力机制和自注意力机制、Transformer的架构概述、Encoder的多头注意力(Multi-Head Attention)、Encoder的位置编码(Positional Encoding)、残差链接、层规范化(Layer Normalization)、FFN(Feed Forward Network)、Transformer的训练及性能、Transformer的机器翻译工作流程。 代码精讲部分使用Jupyter Notebook对Transformer的PyTorch代码进行逐行解读,包括:安装PyTorch、Transformer的Encoder代码解读、Transformer的Decoder代码解读、Transformer的超参设置代码解读、Transformer的训练示例(人为随机数据)代码解读、Transformer的训练示例(德语-英语机器翻译)代码解读。相关课程: 《Transformer原理与代码精讲(PyTorch)》https://edu.csdn.net/course/detail/36697《Transformer原理与代码精讲(TensorFlow)》https://edu.csdn.net/course/detail/36699《ViT(Vision Transformer)原理与代码精讲》https://edu.csdn.net/course/detail/36719《DETR原理与代码精讲》https://edu.csdn.net/course/detail/36768《Swin Transformer实战目标检测:训练自己的数据集》https://edu.csdn.net/course/detail/36585《Swin Transformer实战实例分割:训练自己的数据集》https://edu.csdn.net/course/detail/36586 <https://edu.csdn.net/course/detail/36586>《Swin Transformer原理与代码精讲》 https://download.csdn.net/course/detail/37045注意力机制机器翻译深度学习transformerpytorch

3250人 学习人数4.8分 课程评分Transformer原理与代码精讲(PyTorch)Transformer发轫于NLP(自然语言处理),并跨界应用到CV(计算机视觉)领域。目前已成为深度学习的新范式,影响力和应用前景巨大。 本课程对Transformer的原理和PyTorch代码进行精讲,来帮助大家掌握其详细原理和具体实现。 原理精讲部分包括:注意力机制和自注意力机制、Transformer的架构概述、Encoder的多头注意力(Multi-Head Attention)、Encoder的位置编码(Positional Encoding)、残差链接、层规范化(Layer Normalization)、FFN(Feed Forward Network)、Transformer的训练及性能、Transformer的机器翻译工作流程。 代码精讲部分使用Jupyter Notebook对Transformer的PyTorch代码进行逐行解读,包括:安装PyTorch、Transformer的Encoder代码解读、Transformer的Decoder代码解读、Transformer的超参设置代码解读、Transformer的训练示例(人为随机数据)代码解读、Transformer的训练示例(德语-英语机器翻译)代码解读。相关课程: 《Transformer原理与代码精讲(PyTorch)》https://edu.csdn.net/course/detail/36697《Transformer原理与代码精讲(TensorFlow)》https://edu.csdn.net/course/detail/36699《ViT(Vision Transformer)原理与代码精讲》https://edu.csdn.net/course/detail/36719《DETR原理与代码精讲》https://edu.csdn.net/course/detail/36768《Swin Transformer实战目标检测:训练自己的数据集》https://edu.csdn.net/course/detail/36585《Swin Transformer实战实例分割:训练自己的数据集》https://edu.csdn.net/course/detail/36586 <https://edu.csdn.net/course/detail/36586>《Swin Transformer原理与代码精讲》 https://download.csdn.net/course/detail/37045注意力机制机器翻译深度学习transformerpytorch

1905人 学习人数5.0分 课程评分Transformer原理与代码精讲(TensorFlow)Transformer发轫于NLP(自然语言处理),并跨界应用到CV(计算机视觉)领域。目前已成为深度学习的新范式,影响力和应用前景巨大。 本课程对Transformer的原理和TensorFlow 2代码进行精讲,来帮助大家掌握其详细原理和具体实现。 原理精讲部分包括:注意力机制和自注意力机制、Transformer的架构概述、Encoder的多头注意力(Multi-Head Attention)、Encoder的位置编码(Positional Encoding)、残差链接(Residual Connection)、层规范化(Layer Normalization)、FFN(Feed Forward Network)、Transformer的训练及性能、Transformer的机器翻译工作流程。 代码精讲部分使用Jupyter Notebook对Transformer的TensorFlow 2实现代码进行逐行解读,包括:安装TensorFlow、Transformer的数据集加载与预处理代码解读、Transformer的位置编码与多头注意力代码解读、Transformer的Transformer类代码解读、Transformer的优化器与损失函数代码解读、Transformer的训练代码解读、Transformer的推理与权重保存代码解读。相关课程: 《Transformer原理与代码精讲(PyTorch)》https://edu.csdn.net/course/detail/36697《Transformer原理与代码精讲(TensorFlow)》https://edu.csdn.net/course/detail/36699《ViT(Vision Transformer)原理与代码精讲》https://edu.csdn.net/course/detail/36719《DETR原理与代码精讲》https://edu.csdn.net/course/detail/36768《Swin Transformer实战目标检测:训练自己的数据集》https://edu.csdn.net/course/detail/36585《Swin Transformer实战实例分割:训练自己的数据集》https://edu.csdn.net/course/detail/36586 <https://edu.csdn.net/course/detail/36586>《Swin Transformer原理与代码精讲》 https://download.csdn.net/course/detail/37045注意力机制tensorflow机器翻译深度学习transformer

1905人 学习人数5.0分 课程评分Transformer原理与代码精讲(TensorFlow)Transformer发轫于NLP(自然语言处理),并跨界应用到CV(计算机视觉)领域。目前已成为深度学习的新范式,影响力和应用前景巨大。 本课程对Transformer的原理和TensorFlow 2代码进行精讲,来帮助大家掌握其详细原理和具体实现。 原理精讲部分包括:注意力机制和自注意力机制、Transformer的架构概述、Encoder的多头注意力(Multi-Head Attention)、Encoder的位置编码(Positional Encoding)、残差链接(Residual Connection)、层规范化(Layer Normalization)、FFN(Feed Forward Network)、Transformer的训练及性能、Transformer的机器翻译工作流程。 代码精讲部分使用Jupyter Notebook对Transformer的TensorFlow 2实现代码进行逐行解读,包括:安装TensorFlow、Transformer的数据集加载与预处理代码解读、Transformer的位置编码与多头注意力代码解读、Transformer的Transformer类代码解读、Transformer的优化器与损失函数代码解读、Transformer的训练代码解读、Transformer的推理与权重保存代码解读。相关课程: 《Transformer原理与代码精讲(PyTorch)》https://edu.csdn.net/course/detail/36697《Transformer原理与代码精讲(TensorFlow)》https://edu.csdn.net/course/detail/36699《ViT(Vision Transformer)原理与代码精讲》https://edu.csdn.net/course/detail/36719《DETR原理与代码精讲》https://edu.csdn.net/course/detail/36768《Swin Transformer实战目标检测:训练自己的数据集》https://edu.csdn.net/course/detail/36585《Swin Transformer实战实例分割:训练自己的数据集》https://edu.csdn.net/course/detail/36586 <https://edu.csdn.net/course/detail/36586>《Swin Transformer原理与代码精讲》 https://download.csdn.net/course/detail/37045注意力机制tensorflow机器翻译深度学习transformer

1239人 学习人数4.8分 课程评分ViT(Vision Transformer)原理与代码精讲Transformer在许多NLP(自然语言处理)任务中取得了最先进的成果。 ViT (Vision Transformer)是Transformer应用于CV(计算机视觉)领域里程碑式的工作,后面发展出更多的变体,如Swin Transformer。 ViT (Vision Transformer)模型发表于论文An Image is Worth 16X16 Words: Transformer For Image Recognition At Scale,使用纯Transformer进行图像分类。ViT在JFT-300M数据集上预训练后,可超过卷积神经网络ResNet的性能,并且所用的训练计算资源可更少。 本课程对ViT的原理与PyTorch实现代码进行精讲,来帮助大家掌握其详细原理和具体实现。其中代码实现包含两种代码实现方式,一种是采用timm库,另一种是采用einops/einsum。 原理精讲部分包括:Transformer的架构概述、Transformer的Encoder 、Transformer的Decoder、ViT架构概述、ViT模型详解、ViT性能及分析。 代码精讲部分使用Jupyter Notebook对ViT的PyTorch代码进行逐行解读,包括:安装PyTorch、ViT的timm库实现代码解读、 einops/einsum、ViT的einops/einsum实现代码解读。相关课程: 《Transformer原理与代码精讲(PyTorch)》https://edu.csdn.net/course/detail/36697《Transformer原理与代码精讲(TensorFlow)》https://edu.csdn.net/course/detail/36699《ViT(Vision Transformer)原理与代码精讲》https://edu.csdn.net/course/detail/36719《DETR原理与代码精讲》https://edu.csdn.net/course/detail/36768《Swin Transformer实战目标检测:训练自己的数据集》https://edu.csdn.net/course/detail/36585《Swin Transformer实战实例分割:训练自己的数据集》https://edu.csdn.net/course/detail/36586 <https://edu.csdn.net/course/detail/36586>《Swin Transformer原理与代码精讲》 https://download.csdn.net/course/detail/37045vittimmeinsum深度学习transformer

1239人 学习人数4.8分 课程评分ViT(Vision Transformer)原理与代码精讲Transformer在许多NLP(自然语言处理)任务中取得了最先进的成果。 ViT (Vision Transformer)是Transformer应用于CV(计算机视觉)领域里程碑式的工作,后面发展出更多的变体,如Swin Transformer。 ViT (Vision Transformer)模型发表于论文An Image is Worth 16X16 Words: Transformer For Image Recognition At Scale,使用纯Transformer进行图像分类。ViT在JFT-300M数据集上预训练后,可超过卷积神经网络ResNet的性能,并且所用的训练计算资源可更少。 本课程对ViT的原理与PyTorch实现代码进行精讲,来帮助大家掌握其详细原理和具体实现。其中代码实现包含两种代码实现方式,一种是采用timm库,另一种是采用einops/einsum。 原理精讲部分包括:Transformer的架构概述、Transformer的Encoder 、Transformer的Decoder、ViT架构概述、ViT模型详解、ViT性能及分析。 代码精讲部分使用Jupyter Notebook对ViT的PyTorch代码进行逐行解读,包括:安装PyTorch、ViT的timm库实现代码解读、 einops/einsum、ViT的einops/einsum实现代码解读。相关课程: 《Transformer原理与代码精讲(PyTorch)》https://edu.csdn.net/course/detail/36697《Transformer原理与代码精讲(TensorFlow)》https://edu.csdn.net/course/detail/36699《ViT(Vision Transformer)原理与代码精讲》https://edu.csdn.net/course/detail/36719《DETR原理与代码精讲》https://edu.csdn.net/course/detail/36768《Swin Transformer实战目标检测:训练自己的数据集》https://edu.csdn.net/course/detail/36585《Swin Transformer实战实例分割:训练自己的数据集》https://edu.csdn.net/course/detail/36586 <https://edu.csdn.net/course/detail/36586>《Swin Transformer原理与代码精讲》 https://download.csdn.net/course/detail/37045vittimmeinsum深度学习transformer

1828人 学习人数5.0分 课程评分DETR原理与代码精讲Transformer在许多NLP(自然语言处理)任务中取得了最先进的成果。 DETR(Detection Transformer)是Facebook提出的基于Transformer的端到端目标检测方法。DETR使用CNN+Transformer进行图像目标检测,该方法没有NMS后处理步骤、没有anchor。DETR总体思路是把目标检测看成一个set prediction的问题,并且使用Transformer来预测物体边界框的集合。本课程对DETR的原理与PyTorch实现代码进行精讲,来帮助大家掌握其详细原理和具体实现。 原理精讲部分包括:Transformer的架构概述、Transformer的Encoder 、Transformer的Decoder、DETR网络架构、DETR损失函数、DETR实验结果和分析。 代码精讲部分使用Jupyter Notebook对DETR的PyTorch代码进行逐行解读,包括:安装PyTorch、 DETR官方Demo,DETR的hands-on tutorial,DETR的代码精讲(数据准备、Backbone和位置编码、Transformer架构的实现)。相关课程: 《Transformer原理与代码精讲(PyTorch)》https://edu.csdn.net/course/detail/36697《Transformer原理与代码精讲(TensorFlow)》https://edu.csdn.net/course/detail/36699《ViT(Vision Transformer)原理与代码精讲》https://edu.csdn.net/course/detail/36719《DETR原理与代码精讲》https://edu.csdn.net/course/detail/36768《Swin Transformer实战目标检测:训练自己的数据集》https://edu.csdn.net/course/detail/36585《Swin Transformer实战实例分割:训练自己的数据集》https://edu.csdn.net/course/detail/36586 <https://edu.csdn.net/course/detail/36586>《Swin Transformer原理与代码精讲》 https://download.csdn.net/course/detail/37045DETRCNNTransformer计算机视觉目标检测

1828人 学习人数5.0分 课程评分DETR原理与代码精讲Transformer在许多NLP(自然语言处理)任务中取得了最先进的成果。 DETR(Detection Transformer)是Facebook提出的基于Transformer的端到端目标检测方法。DETR使用CNN+Transformer进行图像目标检测,该方法没有NMS后处理步骤、没有anchor。DETR总体思路是把目标检测看成一个set prediction的问题,并且使用Transformer来预测物体边界框的集合。本课程对DETR的原理与PyTorch实现代码进行精讲,来帮助大家掌握其详细原理和具体实现。 原理精讲部分包括:Transformer的架构概述、Transformer的Encoder 、Transformer的Decoder、DETR网络架构、DETR损失函数、DETR实验结果和分析。 代码精讲部分使用Jupyter Notebook对DETR的PyTorch代码进行逐行解读,包括:安装PyTorch、 DETR官方Demo,DETR的hands-on tutorial,DETR的代码精讲(数据准备、Backbone和位置编码、Transformer架构的实现)。相关课程: 《Transformer原理与代码精讲(PyTorch)》https://edu.csdn.net/course/detail/36697《Transformer原理与代码精讲(TensorFlow)》https://edu.csdn.net/course/detail/36699《ViT(Vision Transformer)原理与代码精讲》https://edu.csdn.net/course/detail/36719《DETR原理与代码精讲》https://edu.csdn.net/course/detail/36768《Swin Transformer实战目标检测:训练自己的数据集》https://edu.csdn.net/course/detail/36585《Swin Transformer实战实例分割:训练自己的数据集》https://edu.csdn.net/course/detail/36586 <https://edu.csdn.net/course/detail/36586>《Swin Transformer原理与代码精讲》 https://download.csdn.net/course/detail/37045DETRCNNTransformer计算机视觉目标检测

1735人 学习人数4.7分 课程评分Swin Transformer原理与代码精讲Transformer在许多NLP(自然语言处理)任务中取得了最先进的成果。 Swin Transformer是在ViT基础上发展而来,是Transformer应用于CV(计算机视觉)领域又一里程碑式的工作。它可以作为通用的骨干网络,用于图片分类的CV任务,以及下游的CV任务,如目标检测、实例分割、语义分割等,并取得了SOTA的成果。Swin Transformer获得了ICCV 2021的最佳论文奖。本课程对Swin Transformer的原理与PyTorch实现代码进行精讲,来帮助大家掌握其详细原理和具体实现;并且使用Swin Transformer对17个类别花朵数据集进行图片分类的项目实战。 原理精讲部分包括:Transformer的架构概述、Transformer的Encoder 、Transformer的Decoder、Swin Transformer的网络架构、Patch Merging、SW-MSA、Relative Position Bias、MSA与W-MSA计算量分析、实验结果及性能。 项目实战部分包括:安装软件环境和PyTorch、安装Swin-Transformer、数据集自动划分、修改配置文件、训练数据集、测试训练出的网络模型。 代码精讲部分使用PyCharm对Swin Transformer的PyTorch代码进行逐行解读,包括:PatchEmbed、SwinTransformerBlock、PatchMerging、推理过程和训练过程实现代码解读。 相关课程:Transformer原理与代码精讲(PyTorch)https://edu.csdn.net/course/detail/36697Transformer原理与代码精讲(TensorFlow)https://edu.csdn.net/course/detail/36699ViT(Vision Transformer)原理与代码精讲 https://edu.csdn.net/course/detail/36719 <https://edu.csdn.net/course/detail/36719>DETR原理与代码精讲 https://edu.csdn.net/course/detail/36768 <https://edu.csdn.net/course/detail/36768>Swin Transformer实战目标检测:训练自己的数据集 https://edu.csdn.net/course/detail/36585Swin Transformer实战实例分割:训练自己的数据集 https://edu.csdn.net/course/detail/36586Transformer图像分类计算机视觉人工智能Swin

1735人 学习人数4.7分 课程评分Swin Transformer原理与代码精讲Transformer在许多NLP(自然语言处理)任务中取得了最先进的成果。 Swin Transformer是在ViT基础上发展而来,是Transformer应用于CV(计算机视觉)领域又一里程碑式的工作。它可以作为通用的骨干网络,用于图片分类的CV任务,以及下游的CV任务,如目标检测、实例分割、语义分割等,并取得了SOTA的成果。Swin Transformer获得了ICCV 2021的最佳论文奖。本课程对Swin Transformer的原理与PyTorch实现代码进行精讲,来帮助大家掌握其详细原理和具体实现;并且使用Swin Transformer对17个类别花朵数据集进行图片分类的项目实战。 原理精讲部分包括:Transformer的架构概述、Transformer的Encoder 、Transformer的Decoder、Swin Transformer的网络架构、Patch Merging、SW-MSA、Relative Position Bias、MSA与W-MSA计算量分析、实验结果及性能。 项目实战部分包括:安装软件环境和PyTorch、安装Swin-Transformer、数据集自动划分、修改配置文件、训练数据集、测试训练出的网络模型。 代码精讲部分使用PyCharm对Swin Transformer的PyTorch代码进行逐行解读,包括:PatchEmbed、SwinTransformerBlock、PatchMerging、推理过程和训练过程实现代码解读。 相关课程:Transformer原理与代码精讲(PyTorch)https://edu.csdn.net/course/detail/36697Transformer原理与代码精讲(TensorFlow)https://edu.csdn.net/course/detail/36699ViT(Vision Transformer)原理与代码精讲 https://edu.csdn.net/course/detail/36719 <https://edu.csdn.net/course/detail/36719>DETR原理与代码精讲 https://edu.csdn.net/course/detail/36768 <https://edu.csdn.net/course/detail/36768>Swin Transformer实战目标检测:训练自己的数据集 https://edu.csdn.net/course/detail/36585Swin Transformer实战实例分割:训练自己的数据集 https://edu.csdn.net/course/detail/36586Transformer图像分类计算机视觉人工智能Swin

套餐介绍

Transformer之计算机视觉应用,包含Transformer原理与代码精讲、ViT、DETR、Swin Transformer等应用模型。

资源上传下载、课程学习等过程中有任何疑问或建议,欢迎提出宝贵意见哦~我们会及时处理!

点击此处反馈