150讲轻松学习Python网络爬虫

课时介绍

课程介绍

【为什么学爬虫?】

1、爬虫入手容易,但是深入较难,如何写出高效率的爬虫,如何写出灵活性高可扩展的爬虫都是一项技术活。另外在爬虫过程中,经常容易遇到被反爬虫,比如字体反爬、IP识别、验证码等,如何层层攻克难点拿到想要的数据,这门课程,你都能学到!

2、如果是作为一个其他行业的开发者,比如app开发,web开发,学习爬虫能让你加强对技术的认知,能够开发出更加安全的软件和网站

一个完整的爬虫程序,无论大小,总体来说可以分成三个步骤,分别是:

- 网络请求:模拟浏览器的行为从网上抓取数据。

- 数据解析:将请求下来的数据进行过滤,提取我们想要的数据。

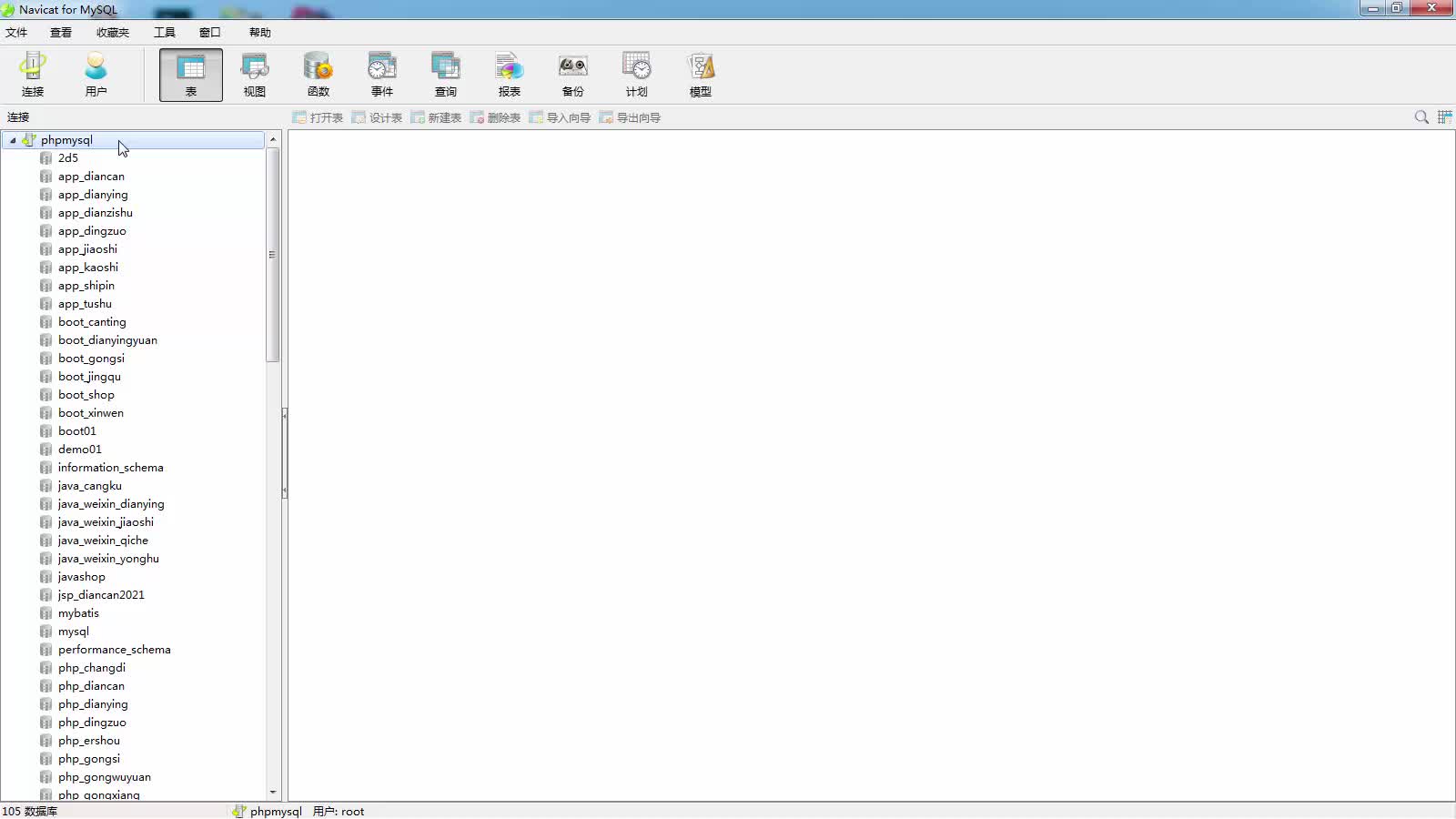

- 数据存储:将提取到的数据存储到硬盘或者内存中。比如用mysql数据库或者redis等。

那么本课程也是按照这几个步骤循序渐进的进行讲解,带领学生完整的掌握每个步骤的技术。另外,因为爬虫的多样性,在爬取的过程中可能会发生被反爬、效率低下等。因此我们又增加了两个章节用来提高爬虫程序的灵活性,分别是:

- 爬虫进阶:包括IP代理,多线程爬虫,图形验证码识别、JS加密解密、动态网页爬虫、字体反爬识别等。

- Scrapy和分布式爬虫:Scrapy框架、Scrapy-redis组件、分布式爬虫等。

通过爬虫进阶的知识点我们能应付大量的反爬网站,而Scrapy框架作为一个专业的爬虫框架,使用他可以快速提高我们编写爬虫程序的效率和速度。另外如果一台机器不能满足你的需求,我们可以用分布式爬虫让多台机器帮助你快速爬取数据。

从基础爬虫到商业化应用爬虫,本套课程满足您的所有需求!

【课程服务】

专属付费社群+定期答疑

信息系统项目管理师自考笔记

李明 · 530人在学

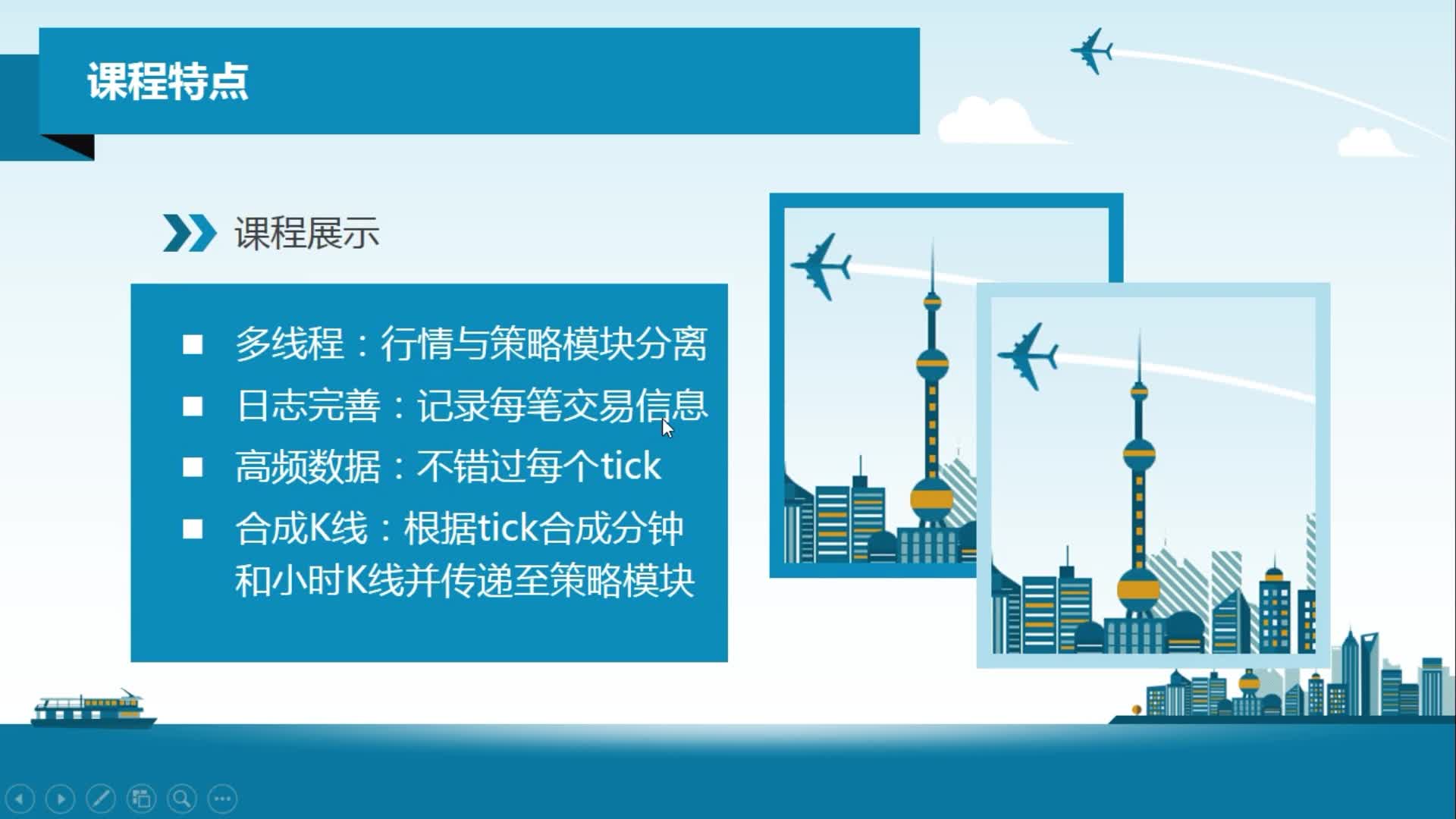

python从0到1:期货量化交易系统(CTP实战,高频及合成K线数据

王先生 · 20768人在学

手把手搭建Java超市管理系统【附源码】(毕设)

汤小洋 · 4090人在学

Java毕设springboot外卖点餐系统 毕业设计毕设源码 使用教

黄菊华 · 734人在学

基于SSM酒店管理系统(毕设)

小尼老师 · 793人在学

java项目实战之购物商城(java毕业设计)

Long · 5101人在学

手把手搭建Java求职招聘系统【附源码】(毕设)

汤小洋 · 1466人在学

Python Django 深度学习 小程序

钟翔 · 2247人在学

城管局门前三包管理系统+微信小程序(vue+springboot)

赖国荣 · 511人在学

Vue+Uni-app(uniapp)入门与实战+赠送仿美团点餐小程序

李杰 · 3869人在学