60分钟带你掌握NLP BERT理论与实战

课时介绍

60分钟带你掌握NLP BERT理论与实战 -3-60分钟带你掌握NLP BERT理论与实战

课程介绍

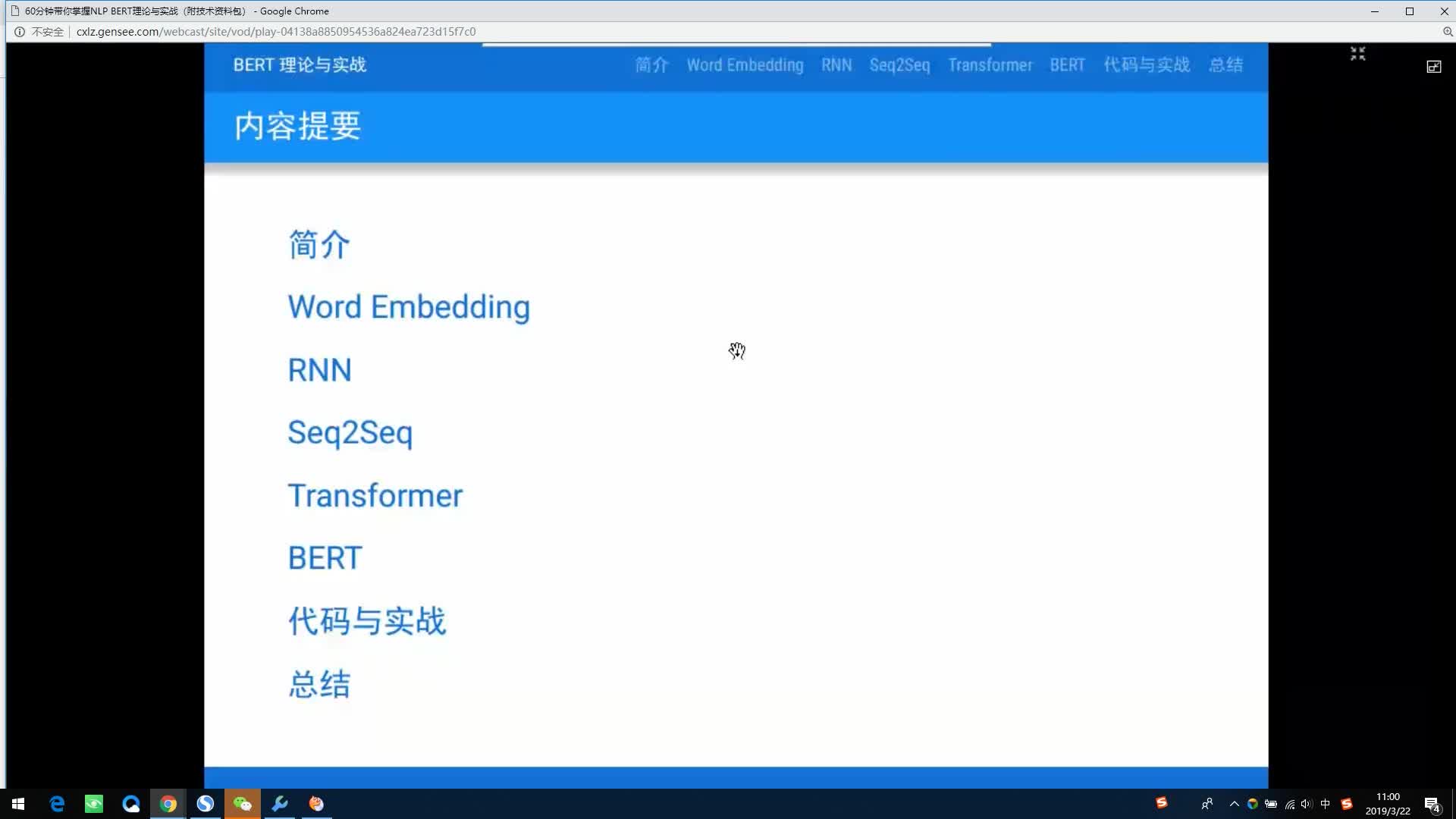

本课程会介绍最近NLP领域取得突破性进展的BERT模型。首先会介绍一些背景知识,包括Word Embedding、RNN/LSTM/GRU、Seq2Seq模型和Attention机制等。然后介绍BERT的基础Transformer模型,这个模型最初用于机器翻译,但是它提出的Self-Attention被用于替换传统的RNN/LSTM/GRU模型。再然后是介绍BERT出现之前的Universal Sentence Embedding模型,包括ELMo和OpenAI GPT。接着介绍BERT模型是什么,它解决了之前模型的哪些问题从而可以达到这么好的效果。代码分析和案例介绍,通过解决实际问题加深理解

推荐课程

信息系统项目管理师自考笔记

李明 · 390人在学

python从0到1:期货量化交易系统(CTP实战,高频及合成K线数据

王先生 · 17710人在学

手把手搭建Java超市管理系统【附源码】(毕设)

汤小洋 · 3760人在学

Java毕设springboot外卖点餐系统 毕业设计毕设源码 使用教

黄菊华 · 668人在学

基于SSM酒店管理系统(毕设)

小尼老师 · 694人在学

java项目实战之购物商城(java毕业设计)

Long · 4931人在学

手把手搭建Java求职招聘系统【附源码】(毕设)

汤小洋 · 1369人在学

Python Django 深度学习 小程序

钟翔 · 2112人在学

城管局门前三包管理系统+微信小程序(vue+springboot)

赖国荣 · 399人在学

Vue+Uni-app(uniapp)入门与实战+赠送仿美团点餐小程序

李杰 · 3540人在学